Aktuell gibt es in der neuen ZDF-Streaming-Plattform knapp 150.000 Videos mit Filmen, Serien-Folgen oder Dokus. Einen besonders schnellen und effektiven Weg zu all diesen Inhalten bietet die Suche, im WWW direkt aufrufbar über https://www.zdf.de/suche.

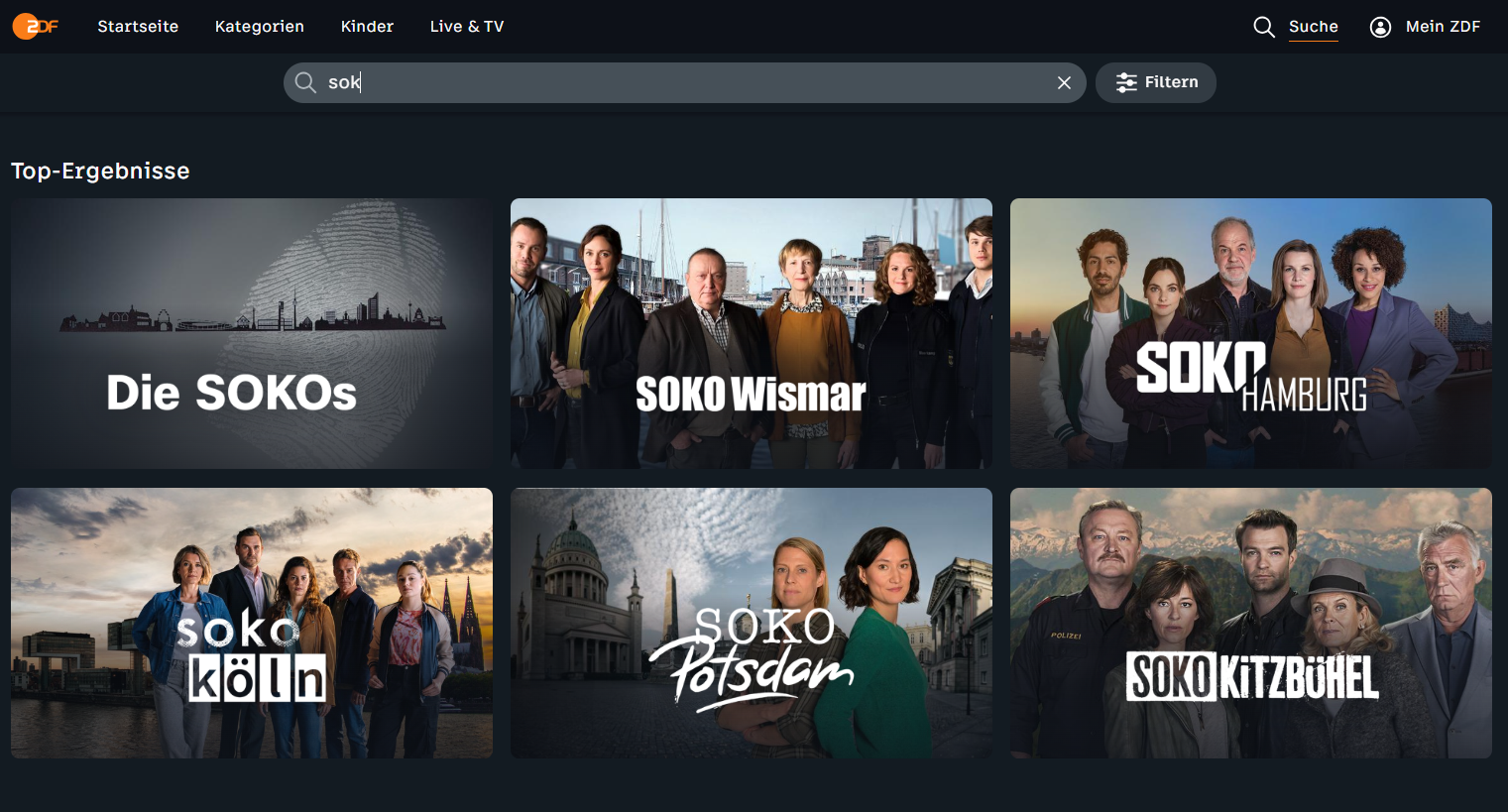

Wer nach einem bestimmten Film sucht, gibt einfach den Titel in das Such-Eingabefeld ein – ein bis drei Buchstaben genügen meist, schon liefert die Suche sekundenschnell die passenden Ergebnisse.

In vielen Fällen kann man sich sogar die - gerade am TV-Gerät mühsame - Eingabe des Suchbegriffs sparen. Nutzende, die auf zdf.de noch nichts gesucht haben, können unter „Meistgefunden“ die Inhalte aufrufen, die gerade eben von vielen anderen gesucht werden. Wer die Suche in der ZDF-Streaming-Plattform schon verwendet hat, erhält an gleicher Stelle unter „Suchhistorie“ direkten Zugriff auf die zuletzt selbst gefundenen Inhalte.

Doch was ist, wenn man gar nicht so genau weiß, was man sehen möchte? Hier bietet die Suche-Seite gleich mehrere Zugänge zu den Highlights im Angebot. Im Band „Kategorien“ lassen sich die Inhalte thematisch sortiert abrufen – von Kultur bis Sport. Auch die A-Z-Liste mit allen Formaten findet sich hier - von Aktenzeichen XY bis ZDFzeit.

Besonders vielfältig ist die Auswahl, die im Band „Entdecken“ geboten wird. Damit die Inhalte so passgenau wie möglich sind, werden hier unterschiedliche Videos angezeigt: Neuen Nutzenden ohne Suchhistorie werden Teaser auf stark genutzte Inhalte angezeigt, unter Berücksichtigung der Nutzung am gleichen Wochentag und zur gleichen Tageszeit. Nutzer:innen mit Suchhistorie bekommen unter dem Titel „Entdecken“ personalisierte Teaser angezeigt, die zu den Inhalten passen, die von ihnen schon einmal gesucht wurden.

Eine Herausforderung ist es, die auf der Suche-Seite angebotenen Teaser richtig zu sortieren – schließlich sollen die passendsten und spannendsten Inhalte möglichst weit vorne stehen. Um das zu gewährleisten, werden die Treffer nach bestimmten Regeln sortiert: Beispielsweise werden neuere Videos höher gewichtet als ältere, ZDF-Inhalte höher als Partner-Inhalte, und je genauer eine Such-Eingabe mit einem Video-Titel übereinstimmt, desto größer ist die Wahrscheinlichkeit, dass ein Video zuvorderst im Such-Ergebnis angezeigt wird.

Immer wieder wird überprüft, wie sich die einzelnen Regeln auswirken. Sind die Such-Ergebnisse nicht passend, muss nachgesteuert werden, etwa indem ein Faktor wie die Aktualität eines Videos mehr oder weniger Gewicht bekommt oder ganz neue Faktoren einbezogen werden – damit alle Nutzenden finden, was sie wollen – ohne lange zu suchen.

Nähere Informationen und Analysen dazu findest du im Anwendungsfall "Suche Einstiegsseite“.